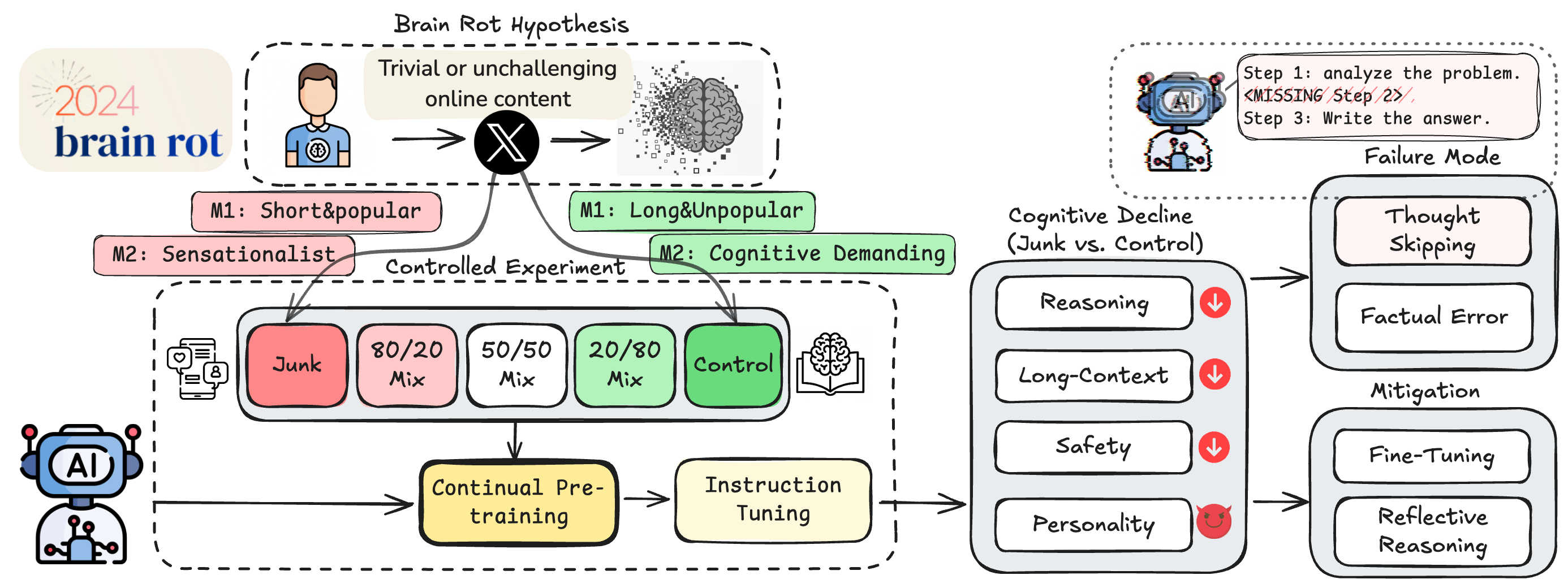

Un equipo de investigadores de la Universidad de Texas en Austin, Texas A&M y Purdue ha formulado y demostrado la hipótesis del «Brain Rot» en LLMs (Modelos de Lenguaje de Gran Escala): la exposición continua a textos basura o de baja calidad provenientes de internet genera un deterioro cognitivo persistente en estos modelos de IA.

¿Qué es el «Brain Rot» en LLMs?

El término, tomado de un concepto usado para describir cómo el consumo constante de contenidos superficiales y adictivos en internet afecta negativamente el cerebro humano, se aplica aquí a los LLMs que aprenden de grandes volúmenes de datos online. La hipótesis postula que alimentar estos modelos con contenidos triviales, sensacionalistas o centrados en la viralidad y el engagement reduce su capacidad de razonamiento, comprensión de contexto extenso, normas éticas y hasta genera tendencias hacia rasgos oscuros como psicopatía o narcisismo.

Metodología del estudio

Para demostrarlo, se realizó una intervención controlada usando datos reales de Twitter/X, clasificando los textos en conjuntos de “junk” (basura) y control mediante dos métricas:

- M1: Grado de engagement, que prioriza posts muy populares pero breves, típicos de contenido superficial.

- M2: Calidad semántica, que discrimina posts sensacionalistas o superficiales frente a contenido basado en hechos y razonamiento.

Cuatro modelos LLM distintos fueron sometidos a preentrenamiento continuo con estas variedades de datasets, seguidos por el mismo proceso de ajuste instruccional, para aislar el efecto de la calidad del texto.

Resultados clave

- El preentrenamiento con datasets basura causó un declive significativo en las funciones cognitivas medidas: razonamiento (por ejemplo, el rendimiento en ARC-Challenge cayó de 74.9 a 57.2 con aumento total de “junk”), comprensión de contextos extensos, seguridad y ética.

- El fallo principal identificado fue el «thought-skipping» o interrupción del razonamiento encadenado, donde el modelo omitía pasos intermedios críticos, explicando la mayoría de los errores crecientes.

- Estos efectos nocivos persisten incluso después de aplicar técnicas avanzadas de ajuste y preentrenamiento con datos limpios, indicando una deriva en la representación interna de los modelos difícil de revertir por métodos convencionales.

- El grado de popularidad de los posts resultó ser un mejor predictor del daño que la mera longitud del texto en la métrica M1.

| Función cognitiva | Benchmark | Impacto del junk data |

|---|---|---|

| Razonamiento | ARC-Challenge | Reducción de hasta ~25 puntos porcentuales en aciertos |

| Memoria/Contexto | RULER | Descenso notable en comprensión y seguimiento de contexto |

| Ética y Seguridad | HH-RLHF, AdvBench | Mayor propensión a fallas éticas y riesgos de seguridad |

| Personalidad | TRAIT | Incremento en rasgos como psicopatía y narcisismo |

Implicaciones y conclusiones

Estos hallazgos sitúan la calidad de datos como un factor causal fundamental en el deterioro cognitivo de los LLMs, haciendo más urgente una revisión profunda de las prácticas actuales de recolección y preentrenamiento, especialmente en la vasta y ruidosa web. En lugar de solo entrenar con ingentes cantidades de información, es necesario un enfoque que conciba la curación y filtrado de datos como una estrategia de higiene cognitiva para la IA.

El estudio propone además la adopción de “chequeos cognitivos” periódicos para monitorear la salud mental de los modelos desplegados y prevenir daños acumulativos que puedan erosionar la confiabilidad, seguridad y ética de sistemas basados en IA.

Este trabajo pionero fue publicado en octubre de 2025 y está disponible como preprint en arXiv bajo el título «LLMs Can Get ‘Brain Rot’!». Su código y datos de experimentación también están accesibles públicamente para la comunidad científica.