La revolución silenciosa que está transformando la industria robótica

Hace apenas tres años, conseguir que un robot recogiera objetos de forma fiable requería ejércitos de ingenieros: especialistas en hardware diseñando garras a medida, equipos de visión por computadora entrenando detectores, teóricos del control afinando bucles PID e ingenieros mecánicos iterando actuadores sin descanso. Hoy, un estudiante universitario puede descargar un modelo vision–language–action de código abierto, afinarlo durante un fin de semana y obtener resultados que antes consumían meses de trabajo industrial.

Esta ruptura de barreras encendió la gran pregunta que recorre laboratorios y fondos de capital riesgo: ¿estamos cerca del ansiado “momento ChatGPT” para la robótica? Aún no hemos llegado, pero las piezas empiezan a encajar. Con el lanzamiento de π-0.5 de Physical Intelligence podríamos situarnos en la fase GPT-3: los modelos ya razonan a través de múltiples modalidades, se adaptan en tiempo real y ejecutan acciones significativas en el mundo físico. Para cruzar la meta faltan iteraciones de hardware cada vez más rápidas, infraestructuras robustas de recolección de datos y despliegues seguros que aprendan sobre la marcha.

¿Qué significa un “momento ChatGPT” en robótica?

El día clave se sentirá tan surrealista como la primera vez que muchos escribimos una pregunta en ChatGPT y recibimos una respuesta sorprendentemente útil. Cuando la robótica llegue a ese punto, no habrá demostraciones vistosas ni comunicados rimbombantes: ocurrirá en la rutina diaria.

El compañero de cuello azul

Un robot nuevo llega a la línea de producción, observa a un operario veterano durante dos turnos, formula un par de preguntas aclaratorias sobre artículos frágiles y, al tercer día, asume sin ruido las tareas pesadas y repetitivas. El trabajador humano se libera para labores de mayor valor, mientras la productividad sube sin interrupciones.

El asistente doméstico invisible

Mientras estás fuera o durmiendo, un robot doméstico incansable patrulla la casa. Ordena habitaciones, pone la lavadora e incluso adelanta la cena. Te das cuenta de su existencia solo porque dejas de pensar en esas obligaciones cotidianas: la magia ocurre en segundo plano.

El estado actual de la autonomía robótica

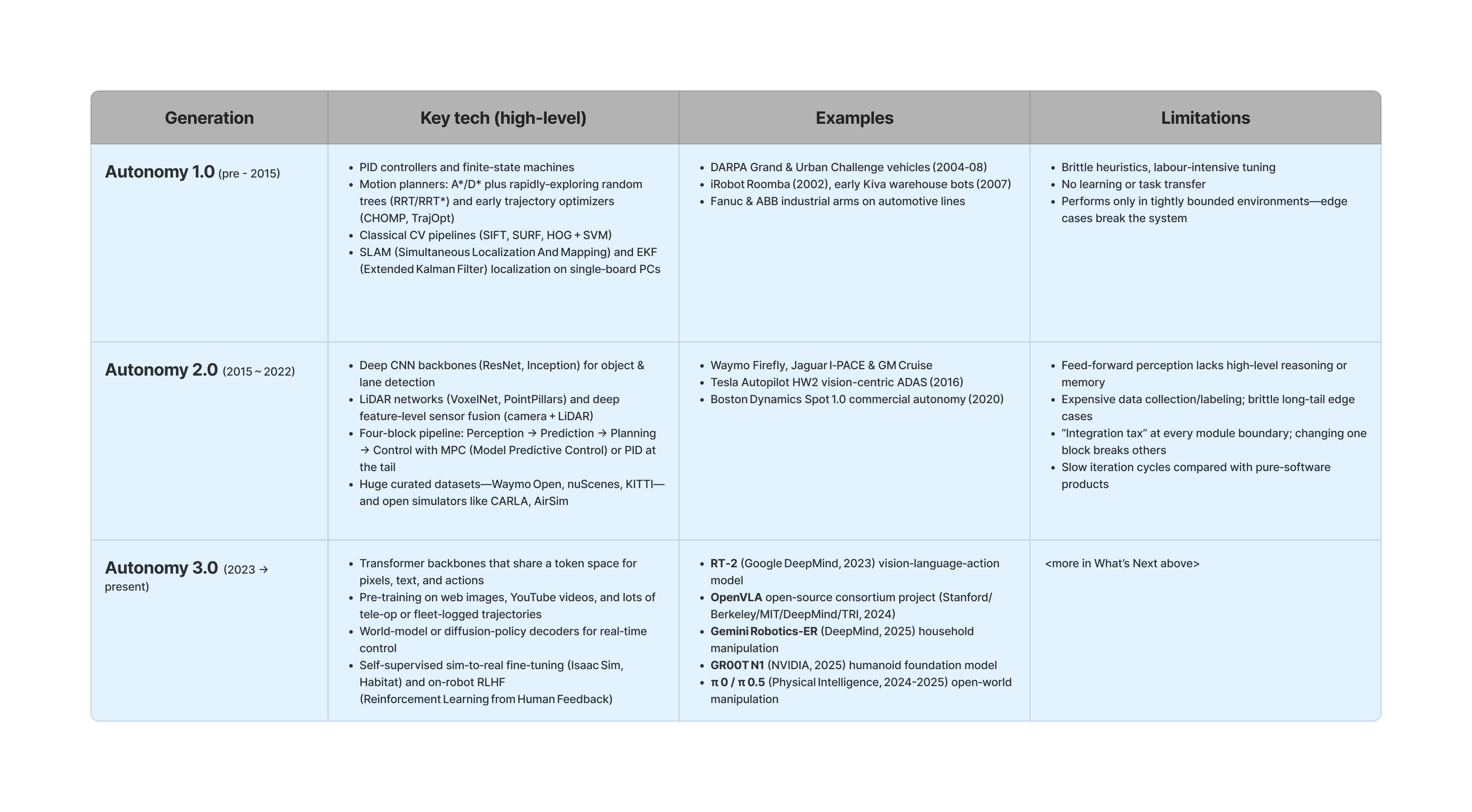

Para medir el progreso, conviene mapear la capacidad de percibir, actuar y adaptarse en cuatro generaciones de autonomía, inspiradas en el marco Software 1.0→3.0 de Andrej Karpathy.

Autonomía 1.0 — Robótica artesanal (pre-2015)

Robots gobernados por reglas fijas y visión clásica basada en features. Funcionaban bien en entornos controlados —DARPA Grand Challenge, primeras Roomba, almacenes Kiva—, pero fallaban ante imprevistos.

Autonomía 2.0 — Deep-Learning modular (2015-2022)

Las CNN dominaron la percepción, aunque planificación y control siguieron basados en reglas. Waymo Firefly, Tesla Autopilot HW2 o Boston Dynamics Spot 1.0 ilustran la tubería Percepción → Predicción → Planificación → Control, eficaz hasta que los casos extremos revelan las costuras.

Autonomía 3.0 — Foundation Models (2023 → presente)

Un único Transformer ingiere vídeo, texto y datos de sensores y devuelve acciones, finamente ajustado en múltiples tareas. Google RT-2, NVIDIA GR00T N1, OpenVLA y π-0.5 insinúan robots que aprenden nuevos oficios en días y justifican sus decisiones en inglés llano.

Autonomía 4.0 — Autonomía colaborativa (futuro)

Swarms con mente colmena sincronizados a un mapa mundial compartido, capaces de repartirse el trabajo al vuelo y leer la intención humana como un compañero. Este estadio sigue en el horizonte, pero ya marca la dirección de inversión.

Factores que aceleran la Autonomía 3.0

Una columna vertebral Transformer unificada sustituye media docena de puntos de traspaso de datos, reduciendo integración y permitiendo aprendizaje extremo a extremo. La percepción multimodal de vocabulario abierto habilita comandos en lenguaje natural y reconocimiento de objetos inéditos. La adaptación rápida de tareas convierte a un único modelo pre-entrenado en especialista de montacargas, drones o humanoides tras pocos días de fine-tuning. Por último, la rueda de datos auto-reforzante —tele-operación, registro de fallos raros y actualizaciones nocturnas— incrementa la fiabilidad de toda la flota mientras dormimos.

Startups que marcan el paso

- Humanoides de pila completa: Tesla Optimus, Figure AI, 1X, Agility Robotics, Boston Dynamics, entre otros.

- Plataformas de inteligencia robótica universal: Physical Intelligence, Skild AI, Gemini Robotics, Hugging Face LeRobot.

- Manipuladores móviles y AMR: Amazon Robotics, Dexterity, Collaborative Robotics.

- Vehículos autónomos: Wayve AI, Tesla FSD, Waymo.

- Autonomía para defensa: Shield AI, Anduril, Blue Water Autonomy.

Obstáculos críticos hacia la Autonomía 3.0

| Desafío | Brecha actual | Hito liberador |

|---|---|---|

| 1. Cognición y memoria | El modelo olvida metas y estado del mundo en segundos. | Memorias de trabajo de minutos y mapas 4-D persistentes. |

| 2. Aprendizaje in-situ | Adaptación lenta y costosa sobre hardware. | Imitación interactiva + RL en pocas horas con supervisión segura. |

| 3. Inferencia en el borde | Alta latencia y consumo energético. | Backbones unificados optimizados para ejecutarse con baterías móviles. |

| 4. Recolección de datos | Coste elevado por hora anotada. | Herramientas de tele-op que capturen horas ricas por turno y se sincronicen en la nube. |

| 5. Brecha sim-to-real | Física de contacto mal modelada. | Motores que logren >90 % de transferencia directa a hardware. |

| 6. Hardware asequible | Actuadores y baterías con ciclos de varios años, caros. | Motores de alto par a cientos de euros y baterías de turno completo. |

| 7. Manipulación delicada | Falta precisión sub-milímetro y control de fuerza fino. | Lazos hápticos sub-ms y sensores táctiles densos. |

| 8. Seguridad formal | Sin garantías deterministas de no dañar a humanos. | Barandillas probables matemáticamente que envuelvan cualquier política. |

Pronóstico: quién ganará y por qué

Las empresas que resuelvan primero un flujo de trabajo doloroso obtendrán ventaja competitiva inmediata. Permanecer en planta, compartir riesgos operativos y refinar fiabilidad hasta que la novedad pase a rutina es la vía más corta hacia ingresos recurrentes.

Por contraste, los humanoides “para todo” son apuestas de alto riesgo: exigen capital masivo, década de desarrollo y avances heroicos en regulación. Tesla Optimus juega con ventaja por su integración vertical, pero la mayoría de start-ups podría agotar caja antes de alcanzar mercado.

El gran tapado podría ser la robótica china. Occidente domina la IA embebida, pero Asia lidera la fabricación de actuadores y sensores a precios imbatibles. Mientras la brecha de costes persista, los fabricantes chinos podrían conquistar segmentos enteros y presionar los márgenes globales.

Conclusión: el futuro llega sin estridencias

Con independencia de quién tome la delantera, pronto nos veremos rodeados de robots en contextos cotidianos. Cuando doblar ropa, descargar camiones o preparar ingredientes sea sencillamente “lo que hace el robot”, sabremos que el “momento ChatGPT” de la robótica habrá llegado sin fanfarrias, integrándose de forma orgánica en nuestra vida diaria.