Un artículo publicado en la revista Nature describe la tecnología detrás del modelo de inteligencia artificial de Meta, capaz de traducir 200 idiomas diferentes. Este avance amplía significativamente el número de idiomas que se pueden traducir mediante traducción automática.

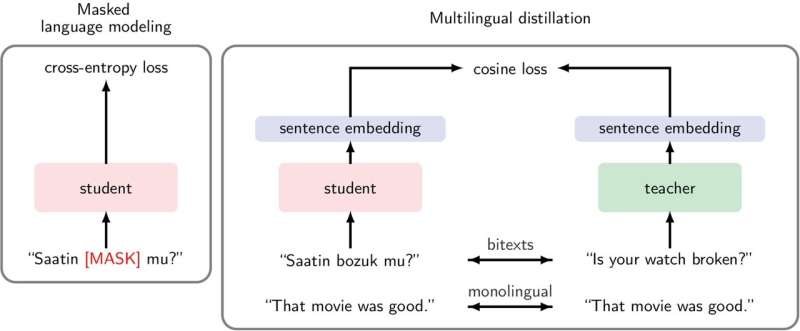

Los modelos de traducción automática neuronal utilizan redes neuronales artificiales para traducir idiomas. Estos modelos generalmente requieren una gran cantidad de datos accesibles en línea para entrenarse, lo cual puede no estar disponible de forma pública, barata o común para algunos idiomas, denominados «idiomas con pocos recursos». Aumentar el número de idiomas que un modelo puede traducir podría afectar negativamente la calidad de las traducciones.

Marta Costa-jussà y el equipo de No Language Left Behind (NLLB) han desarrollado un enfoque interlingüístico que permite a los modelos de traducción automática neuronal aprender a traducir idiomas con pocos recursos utilizando su capacidad preexistente para traducir idiomas con muchos recursos.

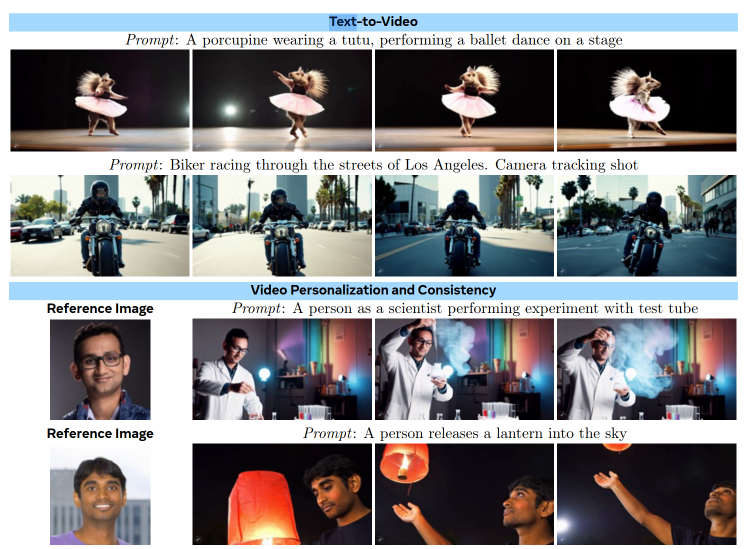

Como resultado, los investigadores han desarrollado una herramienta de traducción multilingüe en línea, llamada NLLB-200, que incluye 200 idiomas, contiene tres veces más idiomas con pocos recursos que idiomas con muchos recursos, y ofrece un rendimiento un 44% mejor que los sistemas preexistentes.

Dado que los investigadores solo tenían acceso a entre 1,000 y 2,000 muestras de muchos idiomas con pocos recursos, para aumentar el volumen de datos de entrenamiento para NLLB-200 utilizaron un sistema de identificación de idiomas para identificar más instancias de esos dialectos específicos. El equipo también recopiló datos textuales bilingües de archivos de Internet, lo que ayudó a mejorar la calidad de las traducciones proporcionadas por NLLB-200.

Los autores destacan que esta herramienta podría ayudar a las personas que hablan idiomas raramente traducidos a acceder a Internet y otras tecnologías. Además, señalan la educación como una aplicación particularmente significativa, ya que el modelo podría ayudar a quienes hablan idiomas con pocos recursos a acceder a más libros y artículos de investigación. Sin embargo, Costa-jussà y sus coautores reconocen que aún pueden ocurrir errores de traducción.