Los centros de datos exageran su consumo de agua, afirma un informe que compara peras con manzanas

El consumo de agua de la inteligencia artificial ha sido exagerado enormemente, según un nuevo informe publicado por Google, que afirma que los avances en software han reducido el consumo de agua de Gemini por consulta a aproximadamente cinco gotas de agua, sustancialmente menos que las estimaciones previas.

Presumiendo una nueva metodología de prueba integral, Google estima que sus aplicaciones Gemini consumen 0.24 vatios hora de electricidad y 0.26 mililitros (ml) de agua para generar una consulta de texto de longitud media.

Google señala que esto es mucho menos que los 45ml a 47.5ml de agua que Mistral AI y los investigadores de UC Riverside han dicho que se requieren para generar aproximadamente una página de texto usando un modelo de tamaño medio, como Mistral Large 2 o GPT-3.

Sin embargo, las afirmaciones de Google son engañosas porque establecen una falsa equivalencia entre el consumo de agua in situ y el consumo total de agua, según Shaolei Ren, profesor asociado de ingeniería eléctrica y computacional en UC Riverside y uno de los autores de los documentos citados en el informe de Google.

El problema del agua: consumo directo vs. total

Para entender por qué, es importante saber que los centros de datos consumen agua tanto dentro como fuera de sus instalaciones.

Las instalaciones que consumen mucha energía a menudo emplean torres de refrigeración, que evaporan el agua bombeada hacia ellas. Este proceso enfría el aire que entra a la instalación, evitando el sobrecalentamiento de las CPU y GPU. Usar agua es más eficiente energéticamente que el refrigerante. Según las propias estimaciones de Google, aproximadamente el 80% de toda el agua extraída de las cuencas hidrográficas cerca de sus centros de datos es consumida por refrigeración evaporativa para esos centros de datos.

Pero el agua también se consume en el proceso de generar la energía necesaria para mantener todos esos servidores funcionando. Al igual que los centros de datos, las plantas de gas, carbón y nucleares también emplean torres de refrigeración que también usan mucha agua. Debido a esto, los centros de datos que no consumen agua directamente aún pueden tener un impacto importante en la cuenca hidrográfica local.

Una comparación sesgada

El problema, enfatiza Ren, no es que Google no haya considerado completamente el consumo de agua fuera del sitio. Es que el gigante de búsqueda comparó peras con manzanas: su nueva cifra es solo para el sitio, mientras que la cifra «desacreditada» incluía todo el consumo de agua.

«Si quieres enfocarte en el consumo de agua in situ, está bien, pero si haces eso, también necesitas comparar tus datos in situ con los datos in situ de trabajos previos», dice Ren.

Google no hizo eso. Y no es como si la investigación de UC Riverside no hubiera incluido estimaciones in situ también. Google podría haber hecho una comparación directa pero eligió no hacerlo, sostiene Ren.

«Su práctica no sigue el estándar mínimo que esperamos para cualquier documento, y menos para uno de Google», dijo.

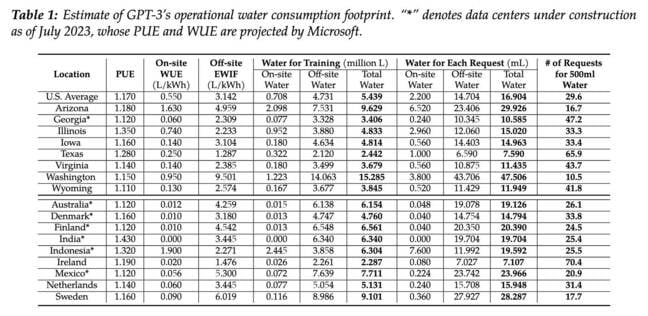

El documento de UC Riverside de 2023 titulado «Making AI Less ‘Thirsty’: Uncovering and Addressing the Secret Water Footprint of AI Models» estimó el consumo de agua in situ del centro de datos promedio estadounidense en 2.2ml por solicitud.

Los 47.5ml por solicitud, que Google redondeó a 50ml en su documento, representaban el consumo de agua total más alto que el equipo de Ren había registrado, y 2.8 veces más alto que el promedio estadounidense.

«No solo eligieron el total, sino que también eligieron nuestro total más alto entre 18 ubicaciones», dijo Ren.

Google responde sin abordar las críticas

Google no respondió a nuestras preguntas sobre la comparación, sino que proporcionó una declaración desacreditando los hallazgos anteriores del investigador de UC Riverside como defectuosos.

«Hemos examinado las afirmaciones en el estudio de UC Riverside, y nuestro equipo de ingenieros de recursos hídricos e hidrólogos ha concluido que las afirmaciones y métodos son defectuosos», dijo Ben Townsend, jefe de estrategia de infraestructura y sostenibilidad en Google. «El defecto crítico en el estudio generalizado de UC Riverside es que asume una red alimentada predominantemente por plantas termoeléctricas tradicionales refrigeradas por agua, lo que no se cumple para las operaciones de centros de datos de Google».

Por qué Google procedió a incorporar datos sobre el uso de agua tanto dentro como fuera del sitio del documento de UC Riverside, el gigante de búsqueda no lo dijo.

¿Mejora real o juego de números?

Aunque los 0.26ml por consulta afirmados por Google siguen siendo sustancialmente menores que el promedio in situ de UC Riverside de 2.2ml para centros de datos estadounidenses, Ren enfatiza que esas cifras fueron publicadas por primera vez en 2023.

Si Google realmente ha logrado reducir la huella energética de Gemini 33 veces en el último año, eso implicaría que el modelo era mucho menos eficiente en agua en el momento en que el equipo de Ren publicó sus resultados también.

La idea de que las cargas de trabajo de IA se volverían más eficientes con el tiempo no es sorprendente, señala Ren. En el documento original, su equipo había predicho mejoras en el consumo de agua y energía.

Esta controversia ilustra la importancia de establecer métricas transparentes y comparables para evaluar el impacto ambiental real de la inteligencia artificial, especialmente cuando las empresas tecnológicas buscan minimizar las preocupaciones sobre su consumo de recursos naturales.