Moonshot AI, la startup china de inteligencia artificial detrás del popular chatbot Kimi, lanzó el viernes un modelo de lenguaje de código abierto que desafía directamente a los sistemas propietarios de OpenAI y Anthropic, destacando especialmente por su rendimiento en tareas de programación y agentes autónomos.

Un modelo revolucionario con arquitectura innovadora

El nuevo modelo, denominado Kimi K2, cuenta con 1 billón de parámetros totales y 32 mil millones de parámetros activados en una arquitectura mixture-of-experts. La compañía está lanzando dos versiones: un modelo base para investigadores y desarrolladores, y una variante optimizada para instrucciones diseñada para aplicaciones de chat y agentes autónomos.

«Kimi K2 no solo responde; actúa», declaró la empresa en su blog de anuncio. «Con Kimi K2, la inteligencia agéntica avanzada es más abierta y accesible que nunca. No podemos esperar a ver qué construyes».

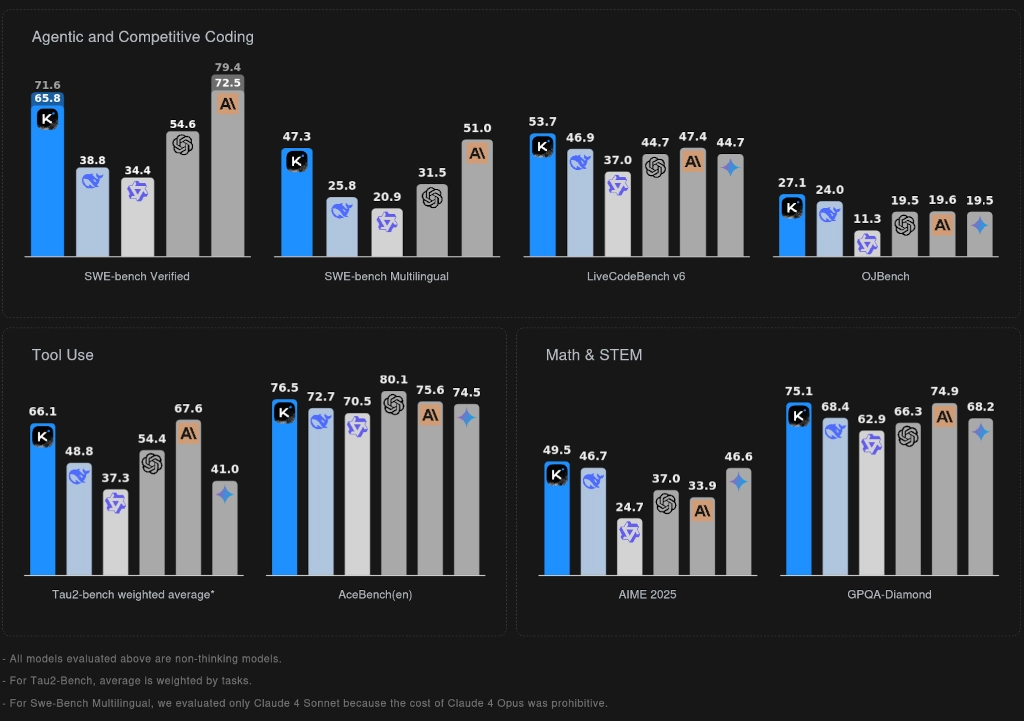

La característica destacada del modelo es su optimización para capacidades «agénticas»: la habilidad de usar herramientas de forma autónoma, escribir y ejecutar código, y completar tareas complejas de múltiples pasos sin intervención humana. En pruebas de rendimiento, Kimi K2 logró un 65.8% de precisión en SWE-bench Verified, un desafiante benchmark de ingeniería de software, superando a la mayoría de alternativas de código abierto y equiparándose con algunos modelos propietarios.

David contra Goliat: Cómo Kimi K2 supera a los modelos millonarios de Silicon Valley

Las métricas de rendimiento cuentan una historia que debería hacer reflexionar a los ejecutivos de OpenAI y Anthropic. Kimi K2-Instruct no solo compite con los grandes jugadores, sino que los supera sistemáticamente en tareas cruciales para clientes empresariales.

En LiveCodeBench, posiblemente el benchmark de programación más realista disponible, Kimi K2 logró un 53.7% de precisión, venciendo decisivamente el 46.9% de DeepSeek-V3 y el 44.7% de GPT-4.1. Aún más impresionante: obtuvo 97.4% en MATH-500 comparado con el 92.4% de GPT-4.1, sugiriendo que Moonshot ha descifrado algo fundamental sobre el razonamiento matemático que ha eludido a competidores más grandes y mejor financiados.

Pero lo que los benchmarks no capturan es que Moonshot está logrando estos resultados con un modelo que cuesta una fracción de lo que los incumbentes gastan en entrenamiento e inferencia. Mientras OpenAI quema cientos de millones en computación para mejoras incrementales, Moonshot parece haber encontrado un camino más eficiente hacia el mismo destino.

El avance de MuonClip: Por qué este optimizador podría transformar la economía del entrenamiento de IA

Enterrado en la documentación técnica de Moonshot hay un detalle que podría ser más significativo que las puntuaciones del modelo en los benchmarks: su desarrollo del optimizador MuonClip, que permitió el entrenamiento estable de un modelo de un billón de parámetros «con cero inestabilidad de entrenamiento».

Esto no es solo un logro de ingeniería, sino potencialmente un cambio de paradigma. La inestabilidad de entrenamiento ha sido el impuesto oculto en el desarrollo de grandes modelos de lenguaje, obligando a las compañías a reiniciar costosos entrenamientos, implementar medidas de seguridad caras y aceptar rendimiento subóptimo para evitar fallos.

Las implicaciones económicas son asombrosas. Si MuonClip demuestra ser generalizable —y Moonshot sugiere que lo es—, la técnica podría reducir drásticamente la sobrecarga computacional del entrenamiento de modelos grandes. En una industria donde los costos de entrenamiento se miden en decenas de millones de dólares, incluso ganancias modestas de eficiencia se traducen en ventajas competitivas medidas en trimestres, no años.

Código abierto como arma competitiva: La estrategia radical de precios de Moonshot apunta a los centros de beneficio de las grandes tecnológicas

La decisión de Moonshot de lanzar Kimi K2 como código abierto mientras ofrece simultáneamente acceso competitivo a API revela una comprensión sofisticada de las dinámicas del mercado que va más allá de los principios altruistas del código abierto.

A $0.15 por millón de tokens de entrada para cache hits y $2.50 por millón de tokens de salida, Moonshot está estableciendo precios agresivamente por debajo de OpenAI y Anthropic mientras ofrece rendimiento comparable —y en algunos casos superior—. Pero la verdadera jugada maestra estratégica es la disponibilidad dual: las empresas pueden comenzar con la API para despliegue inmediato, luego migrar a versiones auto-hospedadas para optimización de costos o requisitos de cumplimiento.

De demostración a realidad: Por qué las capacidades de agente de Kimi K2 señalan el fin del teatro de chatbots

Las demostraciones que Moonshot compartió en redes sociales revelan algo más significativo que capacidades técnicas impresionantes: muestran que la IA finalmente se gradúa de trucos de salón a utilidad práctica.

Considera el ejemplo del análisis salarial: Kimi K2 no solo respondió preguntas sobre datos, sino que ejecutó autónomamente 16 operaciones de Python para generar análisis estadístico y visualizaciones interactivas. La demostración de planificación de conciertos en Londres involucró 17 llamadas a herramientas a través de múltiples plataformas: búsqueda, calendario, email, vuelos, alojamientos y reservas de restaurantes.

Este cambio filosófico se aleja de la generación actual de asistentes de IA que destacan en conversación pero luchan con la ejecución. Mientras los competidores se enfocan en hacer que sus modelos suenen más humanos, Moonshot ha priorizado hacerlos más útiles.

La gran convergencia: Cuando los modelos de código abierto finalmente alcanzaron a los líderes

El lanzamiento de Kimi K2 marca un punto de inflexión que los observadores de la industria habían predicho pero raramente presenciado: el momento en que las capacidades de IA de código abierto genuinamente convergen con las alternativas propietarias.

A diferencia de anteriores «asesinos de GPT» que destacaban en dominios estrechos mientras fallaban en aplicaciones prácticas, Kimi K2 demuestra competencia amplia a través del espectro completo de tareas que definen la inteligencia general. Escribe código, resuelve matemáticas, usa herramientas y completa flujos de trabajo complejos, todo mientras está disponible libremente para modificación y auto-despliegue.

Esta convergencia llega en un momento particularmente vulnerable para los incumbentes de IA. OpenAI enfrenta presión creciente para justificar su valoración de $300 mil millones mientras Anthropic lucha por diferenciar Claude en un mercado cada vez más saturado.

La pregunta ahora no es si los modelos de código abierto pueden igualar a los propietarios —Kimi K2 prueba que ya lo han hecho—. La pregunta es si los incumbentes pueden adaptar sus modelos de negocio lo suficientemente rápido para competir en un mundo donde sus ventajas tecnológicas centrales ya no son defen