Los servicios de chatbots e IA enfrentan un nuevo problema de seguridad que no se puede ignorar. Entrenar modelos de AI requiere grandes cantidades de datos, y los bots escanean constantemente Internet en busca de información valiosa. Sin embargo, este enfoque puede presentar graves riesgos de seguridad, especialmente al tratar con datos altamente sensibles.

Servicios populares de chatbots como Copilot y ChatGPT podrían ser explotados teóricamente para acceder a repositorios de GitHub que sus propietarios han configurado como privados. Según la firma de seguridad israelí Lasso, esta vulnerabilidad es real y afecta a decenas de miles de organizaciones, desarrolladores y grandes empresas tecnológicas.

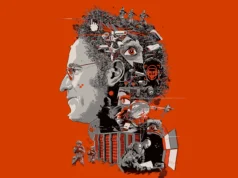

Los investigadores de Lasso descubrieron el problema cuando encontraron contenido de su propio repositorio de GitHub accesible a través de Copilot de Microsoft. El cofundador de la empresa, Ophir Dror, reveló que el repositorio se había hecho público erróneamente por un corto período, durante el cual Bing indexó y almacenó en caché los datos. A pesar de que se volvió a configurar como privado, Copilot aún podía acceder y generar respuestas basadas en su contenido.

«Si estuviera navegando por la web, no vería estos datos. Pero cualquier persona en el mundo podría preguntar a Copilot la pregunta correcta y obtener esos datos», explicó Dror.

Tras experimentar la brecha de seguridad, Lasso realizó una investigación más profunda. La compañía encontró que más de 20,000 repositorios de GitHub que estaban configurados como privados en 2024 seguían siendo accesibles a través de Copilot.

Lasso informó que más de 16,000 organizaciones se vieron afectadas por esta brecha de seguridad generada por AI. El problema también impactó a importantes empresas tecnológicas, incluyendo IBM, Google, PayPal, Tencent, Microsoft y Amazon Web Services. Aunque Amazon negó estar afectado, se informó que Lasso fue presionado por el equipo legal de AWS para eliminar cualquier mención de la compañía de sus hallazgos.

Los repositorios privados de GitHub que permanecieron accesibles a través de Copilot contenían datos altamente sensibles. Cibercriminales y otros actores de amenazas podrían manipular el chatbot para revelar información confidencial, incluyendo propiedad intelectual, datos corporativos, claves de acceso y tokens de seguridad. Lasso alertó a las organizaciones que fueron «severamente» impactadas por la brecha, aconsejándoles rotar o revocar cualquier credencial de seguridad comprometida.

El equipo de seguridad israelí notificó a Microsoft sobre la brecha en noviembre de 2024, pero la compañía clasificó el problema como de «baja gravedad». Microsoft describió el problema de cacheo como un «comportamiento aceptable», aunque Bing eliminó los resultados de búsqueda en caché relacionados con los datos afectados en diciembre de 2024. Sin embargo, Lasso advirtió que incluso después de que se deshabilitó la caché, Copilot aún retiene los datos dentro de su modelo de AI. La compañía ha publicado sus hallazgos de investigación.