Las redes neuronales artificiales, algoritmos inspirados en los cerebros biológicos, están en el núcleo de la inteligencia artificial moderna, impulsando tanto chatbots como generadores de imágenes. Sin embargo, su complejidad interna las convierte en una especie de «cajas negras» cuyo funcionamiento es difícil de interpretar. Ante esta problemática, un grupo de investigadores ha desarrollado una nueva arquitectura de redes neuronales que podría superar a los sistemas tradicionales, ofreciendo mayor interpretabilidad y precisión, incluso con un menor tamaño.

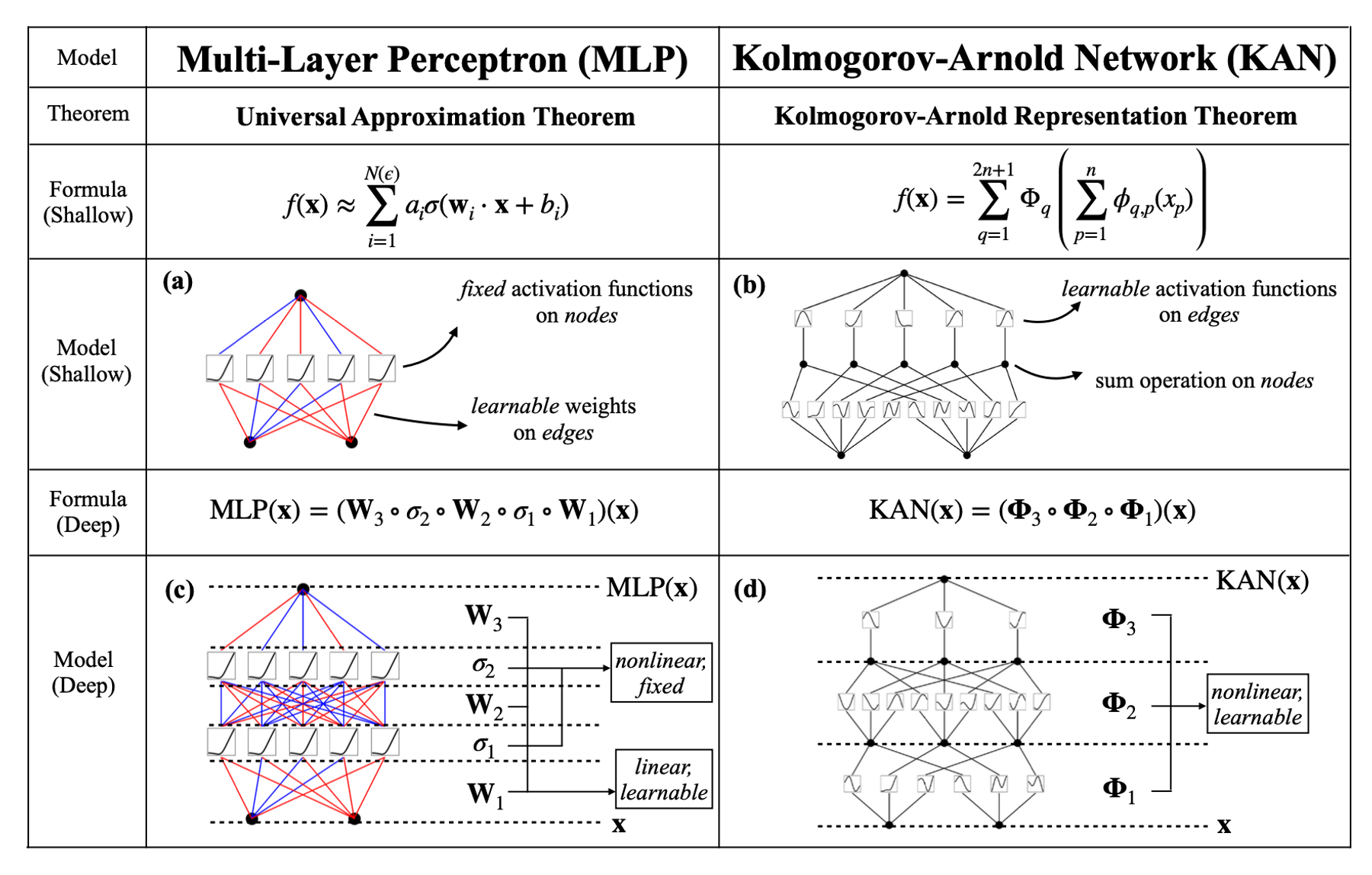

Estas nuevas redes, denominadas Redes Kolmogorov-Arnold (KANs), proponen un enfoque diferente. A diferencia de las redes tradicionales, donde las sinapsis simplemente aprenden la fuerza de conexión entre dos neuronas, las KANs permiten que las sinapsis aprendan la naturaleza completa de esa conexión, utilizando funciones más complejas y adaptativas. Esto no solo simplifica el papel de las neuronas, que se limitan a sumar las salidas de sus sinapsis precedentes, sino que también otorga a las redes una mayor flexibilidad para representar datos con menos parámetros.

Los investigadores probaron las KANs en tareas científicas sencillas, como la representación de leyes físicas, demostrando que estas redes pueden mejorar su rendimiento más rápidamente que las redes tradicionales al aumentar su tamaño. Por ejemplo, una KAN fue capaz de resolver ecuaciones diferenciales con una precisión 100 veces mayor que una red tradicional con 100 veces más parámetros. En otro experimento, las KANs mostraron una precisión superior en la predicción de atributos topológicos de nudos, utilizando una fracción de los parámetros requeridos por las redes tradicionales.

Además de su precisión, las KANs destacan por su capacidad de ser interpretadas visualmente. Los investigadores pueden mapear las funciones de activación y las conexiones dentro de la red, permitiendo simplificar las funciones o eliminar conexiones débiles. En algunos casos, es posible resumir toda la red en una función matemática sencilla, lo que facilita la comprensión y aplicación en investigaciones científicas.

El potencial de las KANs no ha pasado desapercibido. Decenas de estudios ya han citado el trabajo preliminar sobre estas redes, y algunos investigadores han comenzado a combinar KANs con otras arquitecturas, como las redes neuronales convolucionales (CNNs) y los transformadores, para mejorar el procesamiento de imágenes y lenguaje.

A pesar de que las KANs requieren más tiempo de entrenamiento por parámetro, su necesidad de menos parámetros compensa esta desventaja. Aunque es posible que no reemplacen a las grandes redes CNNs y transformadores en todas las aplicaciones, los investigadores ven un gran potencial en su uso para resolver problemas científicos específicos. En el futuro, las KANs podrían ayudar a los físicos a descubrir nuevos principios naturales o a mejorar tecnologías avanzadas, como la superconductividad a alta temperatura o el control de la fusión nuclear.