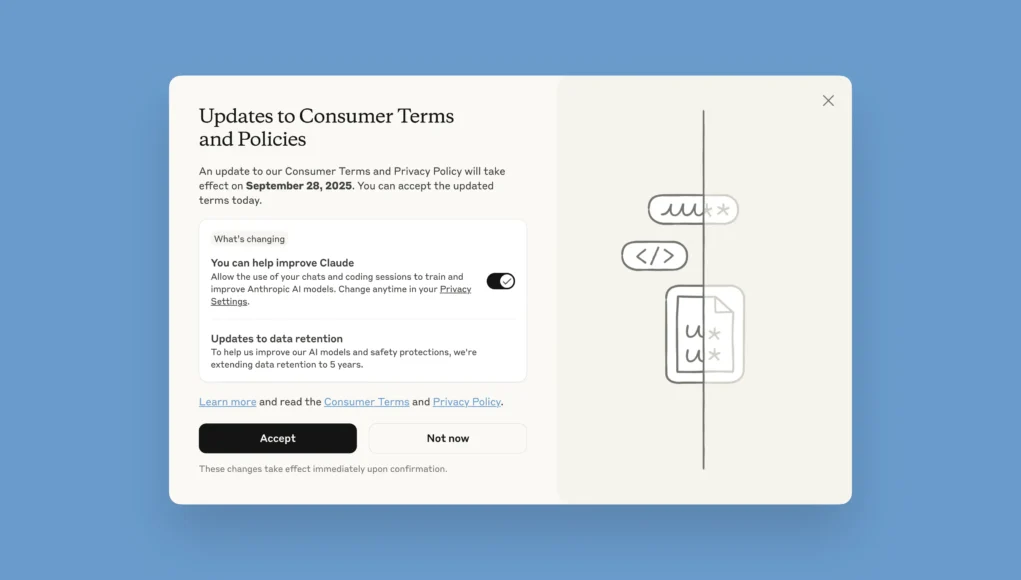

La empresa detrás del asistente de inteligencia artificial Claude ha anunciado cambios significativos en sus Términos de Uso para Consumidores y Política de Privacidad que entrarán en vigor progresivamente. Los usuarios ahora tendrán la opción de permitir que sus datos se utilicen para mejorar los modelos de IA y fortalecer las medidas de seguridad contra usos dañinos.

Qué usuarios se ven afectados

Las actualizaciones aplican exclusivamente para usuarios de los planes Claude Free, Pro y Max, incluyendo cuando utilizan Claude Code desde cuentas asociadas a estos planes. Importante: no afectan a los servicios bajo Términos Comerciales como:

- Claude for Work

- Claude Gov

- Claude for Education

- Uso de API, incluyendo terceros como Amazon Bedrock y Google Cloud’s Vertex AI

Beneficios del programa de entrenamiento

Al participar en este programa, los usuarios contribuirán a:

- Mejorar la seguridad de los modelos, haciendo más precisos los sistemas de detección de contenido dañino

- Reducir falsos positivos que marcan conversaciones inofensivas como problemáticas

- Desarrollar capacidades futuras en habilidades como programación, análisis y razonamiento

Control total sobre tus datos

Anthropic enfatiza que los usuarios mantienen control absoluto sobre esta configuración:

- Usuarios nuevos: pueden seleccionar su preferencia durante el proceso de registro

- Usuarios existentes: verán una ventana emergente para hacer su elección

- Cambios: la configuración puede modificarse en cualquier momento desde Privacy Settings

Fechas importantes

- Usuarios existentes: tienen hasta el 28 de septiembre de 2025 para aceptar los términos actualizados y decidir sobre el entrenamiento de modelos

- Aplicación: las actualizaciones solo afectan chats y sesiones de código nuevos o reanudados

Extensión del período de retención de datos

Una de las modificaciones más significativas es la extensión del período de retención de datos:

- Con participación en entrenamiento: datos se conservan por cinco años

- Sin participación: se mantiene el período actual de 30 días

- Conversaciones eliminadas: no se utilizarán para entrenamiento futuro de modelos

Esta extensión también aplica al feedback que los usuarios envían sobre las respuestas de Claude.

Justificación técnica del cambio

Según Anthropic, esta modificación responde a necesidades técnicas específicas:

Ciclos de desarrollo de IA

- Los modelos liberados hoy comenzaron su desarrollo hace 18 a 24 meses

- Mantener datos consistentes durante todo el proceso de entrenamiento mejora la consistencia de los modelos

- Los modelos entrenados con datos similares responden de manera más uniforme y predecible

Mejora de clasificadores de seguridad

Los sistemas que identifican mal uso se vuelven más efectivos cuando:

- Aprenden de datos recopilados durante períodos más largos

- Pueden detectar mejor patrones de abuso, spam o mal uso

- Contribuyen a mantener Claude seguro para todos

Medidas de privacidad y protección

Anthropic implementa múltiples capas de protección:

- Herramientas automatizadas para filtrar u ofuscar datos sensibles

- Procesos automatizados de protección de información personal

- Política clara: no venden datos de usuarios a terceros

- Flexibilidad: los usuarios pueden cambiar su decisión en cualquier momento

Preguntas frecuentes clave

¿Qué pasa si cambio de opinión?

Si inicialmente permites el entrenamiento y luego cambias de parecer:

- Chats futuros: no se utilizarán para entrenamiento

- Datos históricos: permanecerán en modelos ya entrenados o en entrenamiento

- Entrenamientos futuros: no utilizarán tus chats y sesiones previas almacenadas

¿Por qué este cambio ahora?

Los modelos de lenguaje grandes como Claude se entrenan con enormes cantidades de datos. Las interacciones del mundo real proporcionan insights valiosos sobre qué respuestas son más útiles y precisas. Por ejemplo, cuando un desarrollador depura código colaborando con un modelo de IA, esa interacción ofrece señales valiosas para mejorar modelos futuros en tareas similares de programación.

Esta actualización representa un paso importante en la evolución de Claude hacia sistemas de IA más capaces y seguros, manteniendo siempre el control y la transparencia en manos de los usuarios.