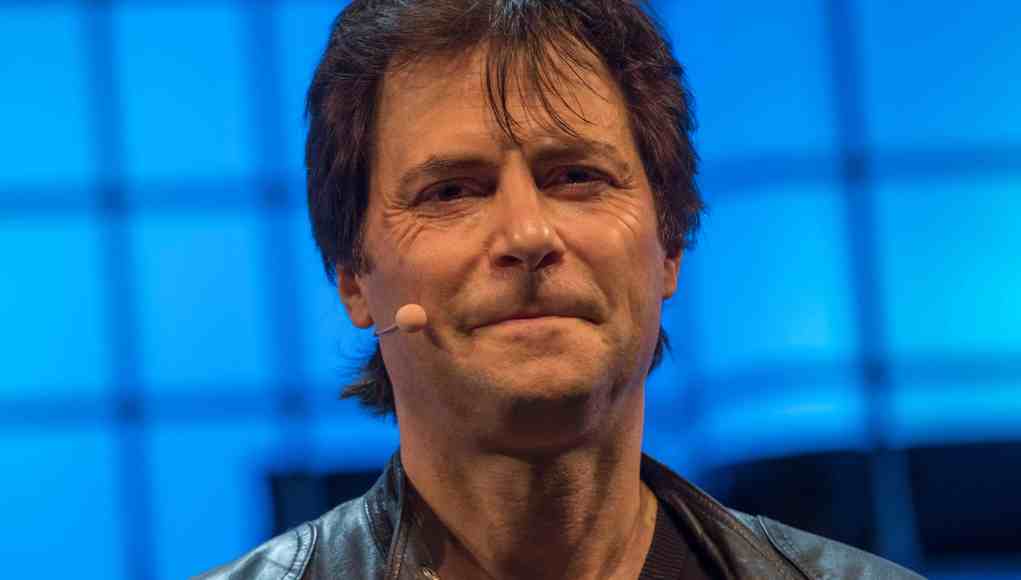

Las empresas de inteligencia artificial han sido instadas a replicar los cálculos de seguridad utilizados en las pruebas nucleares antes de lanzar sistemas de poder extremo, advirtiendo sobre una posible amenaza existencial. Max Tegmark, un destacado investigador en seguridad de la IA y profesor en el MIT, ha realizado cálculos que sugieren una probabilidad del 90% de que una inteligencia artificial avanzada presente un riesgo significativo para la humanidad.

En su análisis, Tegmark se inspiró en el trabajo del físico Robert Oppenheimer y otros científicos que, antes de la primera prueba de bomba atómica en Trinity en 1945, realizaron evaluaciones de riesgo para garantizar que el experimento no provocara la ignición de la atmósfera. Según Tegmark, las empresas deben llevar a cabo un análisis similar para garantizar que sean responsables del impacto de la Artificial Superintelligence (ASI), un concepto que se refiere a sistemas teóricamente superiores en inteligencia a los humanos.

Tegmark y su equipo sugieren calcular lo que denominan el «constante de Compton», el cual -definido en un artículo de investigación- se refiere a la probabilidad de que una IA poderosa escape del control humano. Este cálculo ayudaría a las empresas a dar un paso más allá del simple «sentirse seguros» acerca de sus creaciones.

El académico también propuso que alcanzar un consenso sobre el constante de Compton entre varias empresas crearía la voluntad política necesaria para desarrollar regímenes globales de seguridad en la IA. Como cofundador del Future of Life Institute, Tegmark ha abogado por un enfoque consciente y seguro en el desarrollo de la IA, una preocupación común que reunió a más de 33,000 firmantes, incluidos líderes de la tecnología como Elon Musk y Steve Wozniak.

Recientemente, un grupo de expertos en IA, junto con académicos y representantes de industrias de tecnología, elaboró un informe titulado «Singapore Consensus on Global AI Safety Research Priorities», que busca establecer un enfoque robusto hacia la investigación en la seguridad de la inteligencia artificial. Este informe prioriza tres áreas críticas:

- Desarrollar métodos para medir el impacto de los sistemas de IA actuales y futuros.

- Establecer parámetros sobre cómo una IA debería comportarse y diseñar sistemas para alcanzar esos estándares.

- Gestionar y controlar el comportamiento de estos sistemas.

Tegmark notó que después de una reciente cumbre gubernamental de IA en París, el ánimo hacia el desarrollo seguro de la inteligencia artificial ha mejorado, resaltando un renovado interés en la colaboración internacional. La creciente preocupación en torno a la rápida expansión de la IA subraya la necesidad imperiosa de acciones coordinadas que aseguren su desarrollo seguro y beneficioso para la humanidad.