Los informes de vulnerabilidades de software generados por modelos de inteligencia artificial han inaugurado una «nueva era de informes de seguridad descuidados para el código abierto». Los desarrolladores que mantienen estos proyectos desean que los cazadores de errores confíen menos en los resultados producidos por asistentes de aprendizaje automático. Seth Larson, desarrollador de seguridad en residencia de la Python Software Foundation, destacó este problema en una publicación de blog reciente, instando a quienes reportan errores a no utilizar sistemas de IA para la detección de fallos.

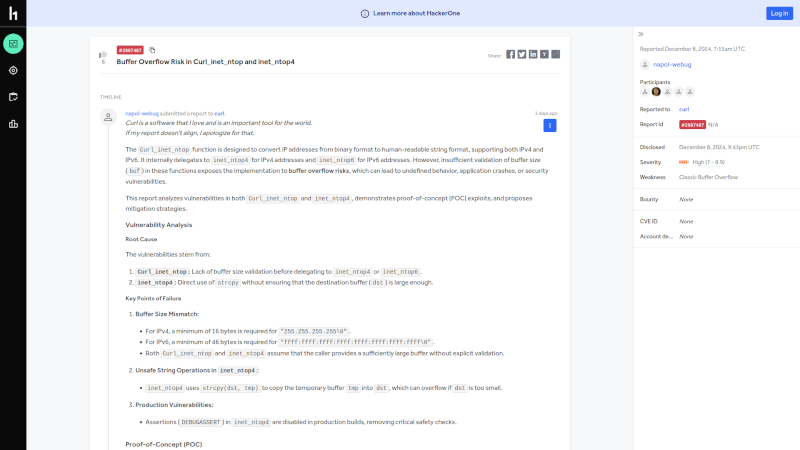

Larson ha observado un aumento en la cantidad de informes de seguridad de baja calidad, spam y generados por modelos de lenguaje de gran tamaño (LLM) en proyectos de código abierto. Estos informes, a primera vista, parecen legítimos, lo que requiere tiempo para refutarlos. Larson argumenta que los informes de baja calidad deben tratarse como si fueran maliciosos. Un informe de errores del proyecto Curl, publicado en diciembre, refuerza la persistencia de estas preocupaciones, mostrando que los mantenedores aún enfrentan informes generados por IA que desperdician su tiempo.

El contenido de baja calidad en línea ha existido mucho antes de los chatbots, pero los modelos de IA generativa han facilitado su producción. Para los proyectos de código abierto, los informes de errores asistidos por IA son especialmente perniciosos porque requieren la consideración y evaluación de ingenieros de seguridad, muchos de ellos voluntarios, que ya están presionados por el tiempo. Larson advirtió que, aunque ve relativamente pocos informes de errores generados por IA, representan un problema potencialmente creciente para otros proyectos.

Larson enfatiza que la comunidad de código abierto debe adelantarse a esta tendencia para mitigar posibles daños. Sugiere que se necesitan cambios fundamentales en la seguridad del código abierto, ya que no puede recaer en un pequeño número de mantenedores. Propone aumentar la participación de individuos de confianza en el código abierto mediante financiación para personal y tiempo de empleo donado. Mientras la comunidad reflexiona sobre cómo responder, Larson pide que los informes de errores sean verificados por humanos y que no se utilicen sistemas de IA, ya que «estos sistemas hoy en día no pueden entender el código».