Safe Superintelligence (SSI), cofundada recientemente por Ilya Sutskever, exjefe científico de OpenAI, ha conseguido una financiación de 1.000 millones de dólares para desarrollar sistemas de inteligencia artificial (IA) que superen las capacidades humanas, según informaron sus ejecutivos a Reuters. SSI, con un equipo actual de 10 empleados, planea utilizar los fondos para adquirir potencia de cálculo y contratar talento de élite. La empresa, con sedes en Palo Alto (California) y Tel Aviv (Israel), se centrará en construir un equipo pequeño y altamente confiable de investigadores e ingenieros.

Aunque la compañía no ha revelado su valoración, fuentes cercanas indicaron que está valorada en 5.000 millones de dólares. Este respaldo financiero refleja que algunos inversores aún están dispuestos a apostar por el talento excepcional enfocado en la investigación de IA fundamental, a pesar del creciente desinterés hacia las startups de este tipo, que pueden ser poco rentables durante largo tiempo. Entre los inversores se encuentran importantes firmas de capital de riesgo como Andreessen Horowitz, Sequoia Capital, DST Global y SV Angel. Además, participaron NFDG, una sociedad de inversión dirigida por Nat Friedman y Daniel Gross, el CEO de SSI.

Gross destacó la importancia de estar rodeados de inversores que comprendan y apoyen su misión: desarrollar una superinteligencia segura, con un enfoque en la investigación antes de lanzar productos al mercado. La seguridad en IA, que busca evitar que esta tecnología cause daños, es un tema candente en medio de temores sobre el potencial de la IA para actuar en contra de los intereses de la humanidad o incluso provocar su extinción.

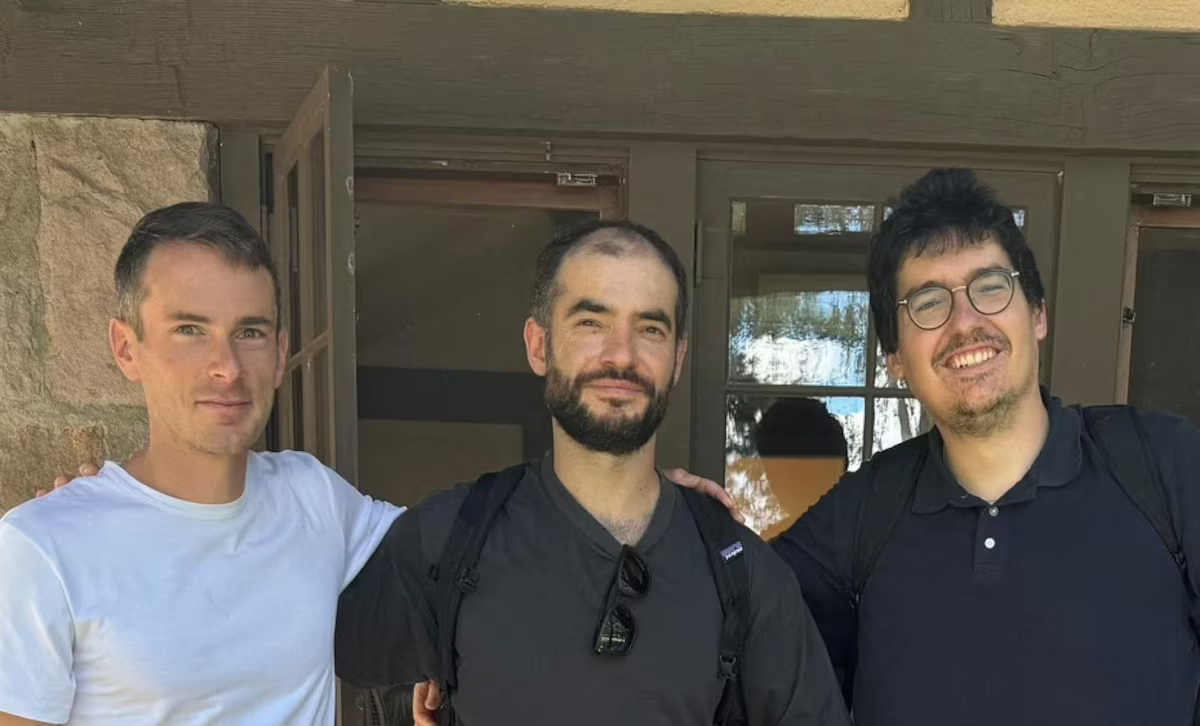

En California, una propuesta de ley para regular la seguridad de las empresas de IA ha dividido a la industria, con opositores como OpenAI y Google, mientras que empresas como Anthropic y xAI, de Elon Musk, la apoyan. Sutskever, considerado uno de los tecnólogos más influyentes en el ámbito de la IA, cofundó SSI en junio junto con Gross, exlíder de iniciativas de IA en Apple, y Daniel Levy, exinvestigador de OpenAI. En SSI, Sutskever ocupa el puesto de jefe científico y Levy es el científico principal, mientras que Gross se encarga de la infraestructura computacional y la recaudación de fondos.

Sutskever señaló que su nuevo proyecto tiene sentido porque ha identificado un enfoque diferente al que estaba trabajando previamente. Tras su salida de OpenAI en mayo, la compañía desmanteló su equipo «Superalignment», que trabajaba para asegurar que la IA se mantuviera alineada con los valores humanos a medida que superara la inteligencia humana.

A diferencia de OpenAI, que tiene una estructura corporativa inusual para asegurar la seguridad de la IA, SSI opera bajo un esquema tradicional con fines de lucro. Gross subrayó que SSI está muy enfocada en contratar personas que encajen en su cultura, priorizando el carácter y las capacidades extraordinarias por encima de las credenciales tradicionales. La empresa aún no ha decidido con qué proveedores de infraestructura trabajará, aunque se espera que colaboren con compañías de computación en la nube y fabricantes de chips.

Sutskever, defensor temprano de la hipótesis del escalado, una teoría que sugiere que los modelos de IA mejoran con grandes cantidades de potencia computacional, comentó que abordará el escalado de manera distinta en SSI. No ofreció detalles, pero sugirió que su enfoque se distanciará del de su anterior empleador, buscando innovar en lugar de seguir el camino tradicional.