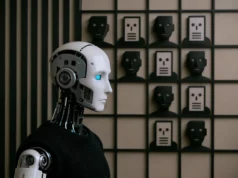

Un alto oficial militar estadounidense está utilizando inteligencia artificial para tomar decisiones de liderazgo cruciales, lo que plantea serias interrogantes sobre la confidencialidad y la seguridad nacional.

El mayor general que confía en la IA

El Mayor General William Hank Taylor, comandante general del 8º Ejército, reveló a Business Insider que está utilizando herramientas de IA como ChatGPT para tomar decisiones que pueden impactar a miles de soldados.

«Como comandante, quiero tomar mejores decisiones», declaró Taylor. «Quiero asegurarme de que tomo decisiones en el momento adecuado para darme la ventaja».

El general admitió que «Chat y yo» se han vuelto «muy cercanos últimamente». Según el Mayor General, ha estado utilizando IA para construir modelos que «ayuden a todos nosotros», especialmente para predecir los próximos pasos basándose en informes semanales.

La teoría del «OODA Loop»

Los comandantes como Taylor creen que la IA podría proporcionar una ventaja debido a un proceso de pensamiento popular entre los líderes militares estadounidenses llamado «OODA Loop». Esta teoría, desarrollada por pilotos de combate estadounidenses durante la Guerra de Corea, establece que las tropas que pueden moverse decisivamente antes que el enemigo —y observar, orientar, decidir y actuar— a menudo tienen la ventaja en el campo de batalla.

Taylor señaló que la tecnología emergente ha sido útil; sin embargo, a menudo es difícil mantenerse al día con las herramientas que se desarrollan rápidamente.

Controversia en torno a la IA militar

La cuestión de la IA en el ejército ha sido controversial. Por un lado, líderes de las Fuerzas Armadas, como el ex Secretario de la Fuerza Aérea, la han elogiado como una herramienta que «va a determinar quién será el ganador en el próximo campo de batalla». También agregó que, al predecir cómo se verá la guerra futura, «vamos a estar en un mundo donde las decisiones no se tomarán a velocidad humana. Se tomarán a velocidad de máquina».

Los riesgos de la tecnología actual

Sin embargo, otros han señalado que programas como ChatGPT-5 —la última iteración de la herramienta— aún cometen errores graves frecuentemente, a menudo presentando información incorrecta o sin sentido como si fuera un hecho. La tecnología también busca a menudo el compromiso y valida a los espectadores en lugar de asegurar que los usuarios estén correctos en sus afirmaciones.

Advertencias de expertos en seguridad

Ed Watal, CEO de Intellibus y cofundador de World Digital Governance, advirtió que el verdadero riesgo en la IA es lo que se ha compartido y hacia dónde van los datos. También alertó contra hacer «preguntas más complejas» que podrían poner información confidencial en manos de chatbots.

«Para que estos modelos sean efectivos y te den una respuesta significativa, necesitan mucho contexto», explicó Watal.

Postura oficial del Pentágono

El Pentágono ha instado previamente a las tropas y líderes a explorar la IA y herramientas similares con precaución, ya que podrían conducir a filtraciones de información sensible o confidencial.

De manera similar, las Naciones Unidas debatieron el mes pasado sobre el uso de la IA en la paz y seguridad internacional, considerándola un arma de doble filo en operaciones militares.

«La IA puede fortalecer la prevención y protección, anticipando la inseguridad alimentaria y el desplazamiento, apoyando el desminado, ayudando a identificar posibles brotes de violencia, y mucho más. Pero sin barreras de protección, también puede ser weaponizada», declaró el Secretario General de la ONU Antonio Guterres.

El dilema de la velocidad vs. seguridad

La adopción de ChatGPT por parte del Mayor General Taylor ilustra el dilema fundamental que enfrenta el ejército moderno: la necesidad de tomar decisiones rápidas en un entorno de combate cada vez más acelerado versus los riesgos de seguridad inherentes al uso de tecnologías de IA comerciales para información militar sensible.

Mientras la tecnología promete ventajas tácticas significativas, las preocupaciones sobre la seguridad de datos y la precisión de la información generada por IA continúan siendo temas críticos que requieren atención inmediata por parte de los responsables de la política de defensa.