Databricks ha desarrollado un método revolucionario que permite a los modelos de inteligencia artificial (IA) mejorar su rendimiento sin la necesidad de contar con datos limpios y etiquetados. Este avance es significativo para las empresas que buscan implementar modelos de IA personalizados, a pesar de los desafíos que plantea el uso de datos imperfectos.

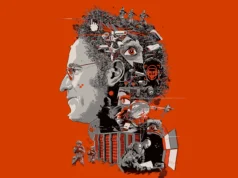

Jonathan Frankle, el principal científico de IA de Databricks, explica que uno de los mayores obstáculos que enfrenta cualquier empresa al implementar IA es la calidad de los datos. Según Frankle, “todos tienen algunos datos y una idea de lo que quieren hacer, pero la falta de datos limpios complica la tarea de ajustar un modelo para realizar una tarea específica”.

El nuevo enfoque de Databricks, llamado Test-time Adaptive Optimization (TAO), permite a las empresas desplegar sus propios agentes para realizar tareas sin que la calidad de los datos sea un impedimento. Este método combina el aprendizaje por refuerzo —una técnica en la que los modelos de IA mejoran mediante la práctica— con datos de entrenamiento “sintéticos”, generados por IA.

Los modelos más recientes de OpenAI, Google y DeepSeek ya utilizan ampliamente el aprendizaje por refuerzo y los datos sintéticos. La técnica de Databricks explota la idea de que, con suficientes intentos, incluso un modelo débil puede alcanzar un buen rendimiento en una tarea específica. Este enfoque se conoce como “best-of-N”.

La metodología permite entrenar un modelo para predecir qué resultado preferirían los evaluadores humanos en base a ejemplos previos. Posteriormente, el modelo de recompensa de Databricks (DBRM) se utiliza para mejorar el rendimiento de otros modelos sin necesidad de nuevos datos etiquetados.

Frankle destaca que el TAO muestra una mejora conforme se aplican a modelos más grandes y potentes. Al emplear esta técnica en la evaluación FinanceBench, se comprobó que el modelo más pequeño de Meta, Llama 3.1B, logró superar a los modelos de OpenAI, alcanzando un resultado del 82.8%, en comparación con el 82.1% de GPT-4o y o3-mini.

Christopher Amato, un científico computacional de la Universidad Northeastern, considera que el TAO es extremadamente prometedor, ya que podría permitir un etiquetado de datos mucho más escalable y mejorar el rendimiento a medida que los modelos evolucionan.

Más allá de las aplicaciones teóricas, Databricks ha demostrado la efectividad del TAO ayudando a sus clientes a implementar modelos de IA confiables. Por ejemplo, una empresa de aplicaciones de rastreo de salud ha visto cómo la técnica permitió desplegar un modelo que previamente no era lo suficientemente confiable para ser usado de manera efectiva.