Un desarrollador independiente ha logrado crear un asistente de inteligencia artificial completamente funcional que opera localmente en una Raspberry Pi 5, sin necesidad de conexión externa ni servicios en la nube.

La capacidad de innovación que permite una Raspberry Pi parece no tener límites. Desde proyectos que hacen los hogares inteligentes aún más eficientes hasta innumerables formas de mejorar espacios cotidianos, este versátil dispositivo ha demostrado su potencial en múltiples ámbitos. Sin embargo, un usuario de GitHub ha llevado esta versatilidad a un nivel completamente nuevo al construir su propio agente de inteligencia artificial local que funciona íntegramente en una Raspberry Pi 5.

Simone Marzulli, el desarrollador detrás de esta innovadora creación, estableció desde el inicio un objetivo aparentemente sencillo pero técnicamente ambicioso: que absolutamente nada saliera de la Raspberry Pi. Esto significaba que ningún proceso de inteligencia artificial debía ser transferido a servicios externos, garantizando así la protección total de los datos del usuario. Además, Marzulli quería que todos estos procesos internos estuvieran alimentados por modelos de lenguaje grandes de código abierto, y que su bot de IA funcionara completamente mediante comandos de voz.

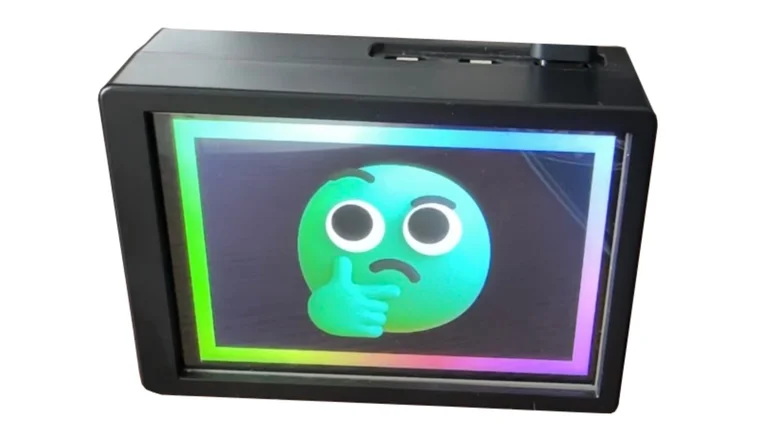

Para materializar su visión, el desarrollador invirtió en un chasis compacto, una pantalla táctil y un sistema de ventilación para su agente alimentado por Pi. El resultado final fue una especie de pantalla inteligente de escritorio que bautizó como Max Headbox, un proyecto que resulta verdaderamente impresionante por su alcance y ejecución.

Un asistente emotivo para tu escritorio

Max Headbox fue diseñado como un bot de IA emotivo basado en pantalla que muestra un rostro animado creado con GIMP utilizando uno de los Fluent Emojis de Microsoft. El sistema responde a comandos de voz una vez que se pronuncia la palabra de activación correspondiente.

Marzulli implementó funcionalidades táctiles que permiten al usuario interactuar con el dispositivo de manera intuitiva. Un simple toque en la pantalla activa el micrófono del sistema para comenzar las indicaciones habladas. Otro toque puede detener la grabación, e incluso es posible cancelar una solicitud mientras el modelo de lenguaje está procesando una respuesta.

La interfaz visual que eligió el desarrollador es deliberadamente sencilla pero efectiva, utilizando cintas giratorias de colores como indicadores principales del estado del sistema. Una cinta azul señala que el dispositivo está listo para escuchar la palabra de activación, el color rojo indica que la voz está siendo grabada, y una animación tipo arcoíris muestra que el modelo de lenguaje está procesando activamente la consulta.

En cuanto a los modelos de código abierto seleccionados, Marzulli optó por Qwen3 1.7b para el modelo agéntico, es decir, la parte que se encarga de la toma de decisiones de Max Headbox. Para el modelo conversacional, que determina cómo el bot reacciona emocionalmente a las indicaciones del usuario, eligió Gemma3 1b.

Equilibrio entre rendimiento y capacidades

Las limitaciones de hardware de la Raspberry Pi obligaron a Marzulli a ser estratégico en la selección de los modelos a ejecutar. Los modelos de lenguaje más grandes habrían saturado completamente la CPU y la memoria del dispositivo, por lo que fue necesario encontrar un equilibrio delicado entre velocidad de respuesta y capacidad expresiva. La solución consistió en utilizar modelos en el rango de mil a dos mil millones de parámetros, un tamaño que permite mantener un rendimiento óptimo sin comprometer excesivamente las funcionalidades del asistente.

Esta decisión técnica demuestra la importancia de adaptar las soluciones de inteligencia artificial a las capacidades reales del hardware disponible, especialmente cuando se busca mantener todo el procesamiento de forma local y privada.

Construye tu propio Max Headbox

Para quienes estén interesados en replicar este proyecto, Simone Marzulli ha documentado minuciosamente todo el proceso en GitHub, incluyendo listas detalladas de componentes, instrucciones paso a paso de configuración y todos los detalles técnicos necesarios.

En términos de hardware, el proyecto requiere una Raspberry Pi 5, habiendo sido probado exitosamente tanto en modelos de 16 GB como de 8 GB de RAM. También se necesita un micrófono USB, para el cual Marzulli recomienda un modelo específico disponible comercialmente, así como una pantalla táctil, carcasa y sistema de refrigeración de la marca GeeekPi para el montaje final del dispositivo.

En el apartado de software, será necesario instalar varios componentes fundamentales en la Raspberry Pi. Estos incluyen Ruby 3.3.0, Node 22, Python 3 y Ollama como plataforma para ejecutar los modelos de lenguaje. Para el control por voz, el sistema se apoya en la API Vosk para manejar la detección de palabras de activación, mientras que faster-whisper proporciona una transcripción de voz rápida y precisa.

Personalización y extensibilidad

Una de las características más atractivas del proyecto es la facilidad con la que se pueden crear herramientas personalizadas que el agente pueda utilizar. El proceso es notablemente sencillo y consiste en crear un módulo JavaScript que exporte un objeto con cuatro campos esenciales: el nombre de la herramienta, los parámetros que acepta, una breve descripción de su función, y la función que ejecuta la tarea específica. Esta arquitectura modular permite a los usuarios adaptar y expandir las capacidades de su asistente según sus necesidades particulares.

Un proyecto al alcance de los entusiastas

Si dispones de un fin de semana largo y disfrutas de los desafíos de bricolaje tecnológico, construir tu propio compañero de IA alimentado por Raspberry Pi está definitivamente al alcance de la mano. Este proyecto demuestra de manera contundente que la inteligencia artificial local no solo es técnicamente posible, sino que puede resultar sorprendentemente efectiva y funcional.