Un equipo de investigadores del MIT y otras instituciones ha desarrollado Neural Jacobian Fields, una innovadora representación de sistemas robóticos que permite a los robots diversos comprender y controlar sus cuerpos utilizando únicamente percepción visual. Esta investigación, publicada en la prestigiosa revista Nature en enero de 2025, marca un hito significativo en el campo de la robótica y la inteligencia artificial.

¿Qué son los Neural Jacobian Fields?

Los Neural Jacobian Fields son una representación de propósito general que permite a los robots inferir campos jacobianos utilizando redes neuronales profundas. En términos simples, esta tecnología permite que robots de diferentes tipos y configuraciones «entiendan donde están sus cuerpos» y cómo controlarlos efectivamente.

El proyecto, liderado por Sizhe Lester Li junto con Annan Zhang, Boyuan Chen, Hanna Matusik, Chao Liu, Daniela Rus y Vincent Sitzmann, proporciona una solución elegante a uno de los desafíos más complejos en robótica: el control adaptativo de sistemas robóticos diversos.

Implementaciones y capacidades técnicas

El framework incluye múltiples implementaciones:

- 3D Jacobian Field: Para sistemas robóticos tridimensionales complejos

- 2D Jacobian Field: Para aplicaciones bidimensionales

- Simulador personalizado: Basado en MuJoCo para entrenamiento y validación

Experimentos y validación

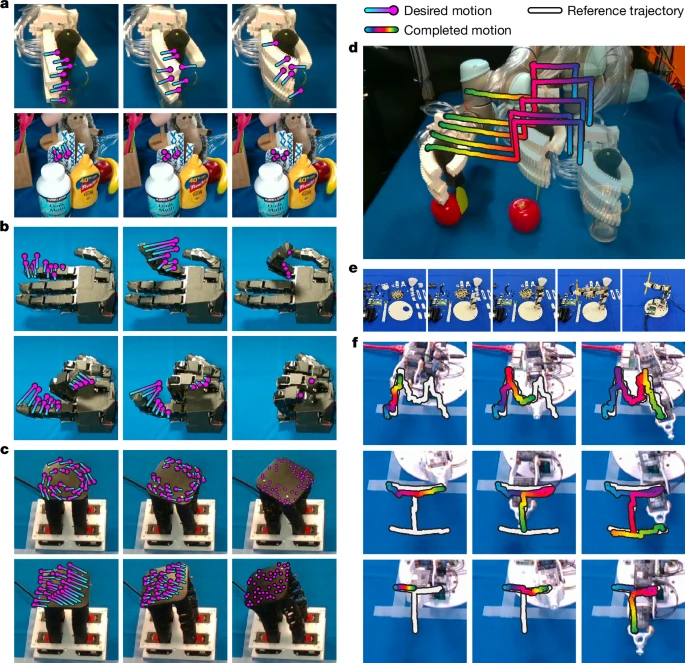

Los investigadores han validado su enfoque tanto en simulaciones como en experimentos del mundo real:

Simulaciones 2D: Incluyen tutoriales interactivos de aproximadamente 30 minutos cada uno:

- Tutorial con robot pusher 2D

- Tutorial con dedo robótico 2D

- Demo de control para empuje de bloques

Experimentos reales: Probados en diversos sistemas robóticos:

- Mano robótica neumática montada en brazo robótico

- Mano robótica Allegro

- Plataforma Handed Shearing Auxetics

- Brazo robótico Poppy

Dataset y recursos disponibles

El equipo ha puesto a disposición de la comunidad científica un dataset multiview video-acción en HuggingFace que incluye poses de cámara y datos de múltiples sistemas robóticos. Esto facilita que otros investigadores puedan construir sobre este trabajo y expandir las aplicaciones.

Herramientas de entrenamiento

El framework proporciona un pipeline completo de entrenamiento que incluye:

- Entrenamiento del módulo de percepción utilizando PixelNeRF

- Entrenamiento de campos jacobianos con extracción de movimiento visual

- Integración con TAPIR para extracción de trayectorias de movimiento

Impacto y aplicaciones futuras

Esta tecnología promete revolucionar múltiples áreas:

- Robótica adaptativa: Robots que pueden ajustarse automáticamente a diferentes configuraciones corporales

- Control intuitivo: Sistemas que aprenden a controlarse mediante observación visual

- Transferencia de conocimiento: Capacidad de aplicar aprendizajes entre diferentes tipos de robots

Reconocimientos y apoyo institucional

El proyecto ha recibido apoyo significativo de instituciones prestigiosas. Vincent Sitzmann fue apoyado por el Solomon Buchsbaum Research Fund del MIT, mientras que Sizhe Lester Li recibió una beca presidencial del MIT. Otros miembros del equipo fueron respaldados por la National Science Foundation y el Gwangju Institute of Science and Technology.

Disponibilidad y acceso

Todo el código fuente está disponible públicamente en GitHub bajo licencia abierta, incluyendo:

- Checkpoints preentrenados

- Tutoriales interactivos

- Demos listos para ejecutar

- Documentación completa

Los investigadores también proporcionan un tutorial detallado y un video explicativo para facilitar la comprensión y adopción de la tecnología.

Este avance supone un paso crucial hacia robots más inteligentes y adaptables que pueden comprender intuitivamente sus propios cuerpos y movimientos, abriendo nuevas posibilidades en automatización, asistencia médica y exploración espacial.