Investigadores del Instituto de Robótica (RI) de la Universidad Carnegie Mellon han desarrollado un sistema innovador para la exploración autónoma con robots aéreos y la coordinación de múltiples robots dentro de estructuras abandonadas. Esta tecnología promete ser de gran utilidad para los equipos de rescate, permitiéndoles recolectar datos y tomar decisiones más inteligentes después de un desastre.

El enfoque del equipo se centra en reducir la exploración redundante, optimizar el uso de recursos y mejorar la eficiencia en la detección de áreas críticas. Según Seungchan Kim, estudiante de doctorado en RI, la coordinación y comunicación entre los robots es esencial para maximizar la exploración de habitaciones, asegurando que cada dron cubra áreas diferentes sin solaparse.

Anualmente, se producen alrededor de 100 terremotos que causan daños significativos, incluyendo la destrucción de edificios y cortes de energía. En estos escenarios, es vital que los equipos de rescate puedan evaluar la situación de manera rápida y segura para priorizar las operaciones de rescate.

El sistema desarrollado permite que los drones se enfoquen en detectar puertas de manera eficiente, ya que las personas y otros objetivos importantes son más probables de encontrarse en habitaciones que en pasillos. Para identificar estas entradas, los robots emplean un sensor lidar que analiza las propiedades geométricas del entorno.

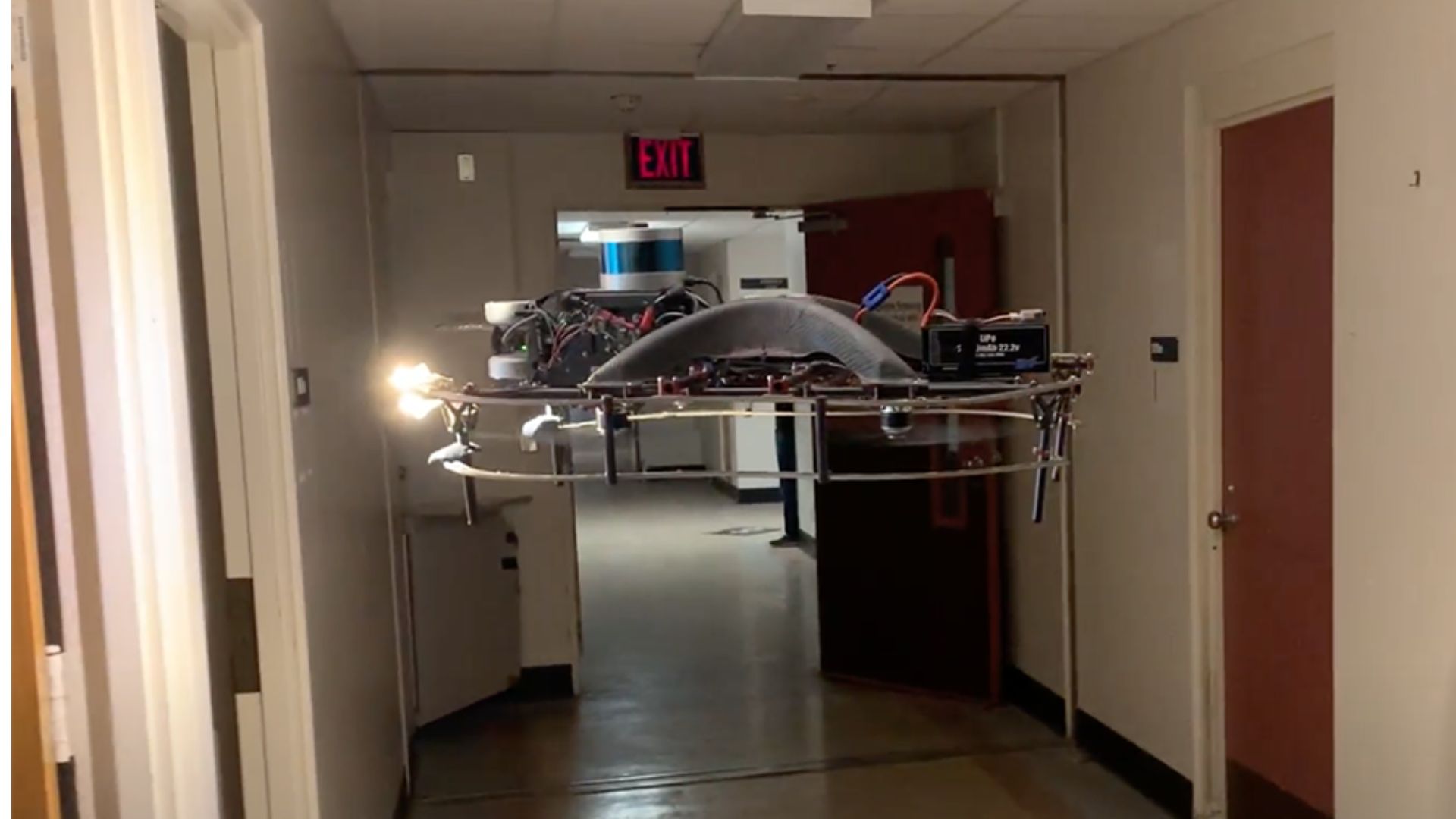

Los drones, que vuelan a unos dos metros sobre el suelo, transforman los datos en 3D del lidar en un mapa 2D que muestra la disposición del espacio como una imagen compuesta de celdas o píxeles. Estos drones pueden así identificar características estructurales como puertas y habitaciones, lo que les permite moverse rápidamente hacia áreas no exploradas.

Las paredes cercanas al dron se representan como píxeles ocupados, mientras que las puertas abiertas o pasajes aparecen como píxeles vacíos. Los investigadores modelaron las puertas como puntos de silla en los datos, lo que facilita que los drones reconozcan y naveguen a través de ellas. Una vez dentro de una habitación, la posición del robot se visualiza en el mapa como un círculo.

El equipo optó por usar sensores lidar en lugar de cámaras por dos razones principales: los sensores requieren menos potencia de procesamiento y son más eficaces en ambientes polvorientos o con humo, condiciones comunes en edificios colapsados o zonas afectadas por desastres naturales.

Los robots operan de manera independiente, comunicándose entre sí y compartiendo información sobre las áreas ya exploradas para evitar la duplicación de esfuerzos. Las pruebas han demostrado que este sistema asigna tareas eficientemente entre los robots y apoya una exploración metódica de las habitaciones.

Las evaluaciones realizadas con hasta tres robots aéreos muestran que este método supera al enfoque tradicional en un 33,4% en simulaciones y un 26,4% en pruebas reales. Sin embargo, debido a la transformación de los datos 3D en 2D, la tecnología actual se limita a edificios de una sola planta y tiene un sistema de evasión de colisiones implícito.